Un giorno della primavera scorsa ho preso l’autobus per il Moscone center, a San Francisco, dove quasi trentamila persone erano riunite per l’annuale Game developers conference (Gdc), il raduno degli sviluppatori di videogiochi a cui partecipavo da giornalista. Avevo trascorso i mesi precedenti in congedo di maternità ed ero contenta di tornare al lavoro, di uscire temporaneamente dalla sfera domestica. Partecipare di nuovo alla vita pubblica mi sembrava incredibile, quasi un sogno psichedelico. Mi faceva piacere chiacchierare con l’autista dell’autobus e origliare quello che dicevano le persone. “Sono tornate le conferenze”, un uomo ha detto a un altro, con aria afflitta. Mentre il mio autobus si allontanava, ho visto che era decorato con una meravigliosa pubblicità della cernia taiwanese. “Ha un sapore delicato ma inconfondibile”, si leggeva sulla fiancata. “Provate una cernia magra e saporita stasera stessa”.

Alla Gdc, skater con tute aderenti nere tempestate di sensori eseguivano acrobazie su una piccola rampa. Persone con il pass dell’evento al collo gironzolavano indossando occhiali per la realtà virtuale. Tutte le pareti erano coperte da schermi e monitor ad alte prestazioni e risoluzione. Quella settimana, giornalisti e rappresentanti dell’industria tecnologica molto attivi su Twitter non facevano altro che parlare dei chatbot con dei chatbot. La OpenAi aveva appena fatto uscire una nuova versione di ChatGpt che stava facendo impazzire tutti. Qualcuno ipotizzava che l’intelligenza artificiale (ia) avrebbe eroso il tessuto sociale e si chiedeva se minacciasse la sopravvivenza di intere professioni.

L’industria dei videogiochi ha sempre fatto affidamento su varie forme di ciò che potrebbe essere definito ia, e almeno due degli interventi alla Gdc hanno affrontato il problema dell’uso di modelli linguistici di grandi dimensioni e dell’ia generativa nei giochi. Si concentravano in particolare sulla costruzione di personaggi non giocanti (non-player character, npc): personaggi semplici e strumentali – abitanti del villaggio, creature della foresta, nemici da combattere e cose simili – che permettono d’inserire brevi battute di sottofondo, chiamate bark: “Ciao”, “Hai sentito?”, “Attenzione!”. Gli npc hanno lo scopo di rendere il gioco più popolato, vivace e multidimensionale, senza distrarre troppo. Nel frattempo, al di fuori dei giochi, sono diventati una sorta di meme. Nel 2018, il Times ha definito la sigla npc come “il nuovo insulto preferito dai sostenitori di Trump”, perché gli utenti di internet di destra avevano cominciato a usarlo per offendere i loro avversari politici, accusandoli di essere stupidi automi sottoposti al lavaggio del cervello dall’ortodossia politica. Oggi, npc può essere usato per definire un’altra persona, o se stessi, come personaggio generico, elementare, riproducibile, accessorio, inerme, con un copione prestabilito.

Quando ho pensato alle potenzialità degli npc creati da modelli linguistici di grandi dimensioni (llm), ho immaginato storie automatizzate, in cui ogni oggetto e personaggio ha una sua personalità: orchi gentili, venditori chiacchieroni, piante che parlano. La realtà è più banale. I personaggi non giocanti “possono parlare al giocatore, tra loro o con se stessi, ma devono farlo senza esitare, senza ripetersi né deviare dalla traccia narrativa”. Questo è in sintesi quanto ha detto nel suo intervento Ben Swanson, ricercatore della Ubisoft, un’azienda di videogiochi francese. Swanson presentava il programma Ghostwriter, progettato per ridurre il complicato lavoro che comporta la creazione di alberi ramificati di dialogo, in cui lo stesso tipo di conversazione si ripete molte volte, leggermente modificato a seconda di ciò che devono dire i giocatori. Ghostwriter usa un modello linguistico di grandi dimensioni per suggerire possibili bark agli npc, sulla base di vari criteri inseriti dagli esseri umani, che poi controllano il risultato. Il giocatore non interagisce direttamente con l’ia.

Eppure sembra probabile che in futuro parlare con l’intelligenza artificiale diventerà una cosa comune. I modelli linguistici di grandi dimensioni sono usati dai motori di ricerca, dai siti di commercio online, dai programmi di scrittura e dai software per fogli di calcolo. In teoria, le capacità degli assistenti vocali, come Siri della Apple o Alexa di Amazon, potrebbero diventare più complesse. Anche i call center stanno introducendo assistenti basati sull’intelligenza artificiale. Sembra che Amazon stia costruendo un chatbot. All’inizio della scorsa primavera, la Khan lab school, una piccola scuola privata di Palo Alto, ha introdotto un bot sperimentale che fa da tutor ai suoi studenti e la National eating disorders association, che si occupa di disturbi alimentari, ha provato a sostituire la sua linea per l’assistenza telefonica con un bot chiamato Tessa, ma ha sospeso il servizio dopo che Tessa ha dato consigli dannosi a chi chiamava.

I chatbot non sono il punto d’arrivo dei modelli linguistici di grandi dimensioni. Probabilmente, le capacità più impressionanti della tecnologia non hanno tanto a che fare con la conversazione quanto con l’elaborazione dei dati – scoprire schemi e imitarli, rielaborare input per generare qualcosa di simile a riassunti – di cui la creazione di dialoghi è solo un aspetto. Eppure, sembra che il futuro possa riservare infinite opportunità per chiacchierare con interlocutori instancabili. Alcuni di questi discorsi saranno scritti e alcuni potrebbero essere condotti attraverso interfacce che rispondono a comandi vocali. Qualsiasi cosa collegata a una banca dati potrebbe effettivamente diventare un bot o un npc nello spazio online e in quello materiale. Forse stiamo entrando in un’epoca caratterizzata da chat inesauribili, utili, accattivanti.

Una chat online è diversa da una conversazione tra persone e tende ad avere un suo flusso. Può essere cacofonica – quando i partecipanti si lanciano a vicenda raffiche di testi brevi – o totalmente asincrona. La posta in gioco di solito è bassa e le opportunità di partecipare sono moltissime. Si può chattare attraverso un’app d’incontri, videogiochi, videochiamate, software di scrittura e così via, per non parlare di WhatsApp o iMessage. La chat tende ad adattarsi alle caratteristiche, ai vincoli e alle convenzioni di una piattaforma. Chattare su Slack è diverso da chattare su Tinder. C’è sempre qualcos’altro da dire e un posto in cui dirlo. Il silenzio può sembrare un miracolo.

Nel 2011 la rivista letteraria n+1 ha pubblicato un saggio barocco e divertente sulle chat intitolato Chathexis. In particolare, esplorava i piaceri unici di Gchat, che allora era il più popolare software di questo tipo . “Gchat riporta la filosofia in camera da letto quando, a tarda notte, ci troviamo in uno stato di concentrazione estatica”, scrivevano. “Molti di noi si sentono al loro meglio su Gchat. Siamo silenziosi, non siamo in grado di parlare con i nostri amici, così diventiamo ascoltatori migliori, ma anche oratori e scrittori migliori”. La chat, osservavano, può essere affettuosa, intima, informale, rivelatrice. Ha anche un sottofondo emotivo. “L’immediatezza di una chat enfatizza la risposta, ricordandoci che quando scriviamo non ci limitiamo a creare ed esprimere noi stessi, ma creiamo ed esprimiamo anche le nostre relazioni”, sostenevano gli autori.

Ciò che i chatbot offrono non è un dialogo, ma una conversazione simulata. Alcuni dei modelli più amichevoli, come Replika (“Il compagno che s’interessa a noi”) o l’ormai quasi pensionata Sydney di Bing, possono avere un ritmo vicino alla realtà. ChatGpt è antropomorfa, nonostante la sua “personalità” asciutta e volutamente meccanica: si scusa quando commette un errore, scrive in prima persona e ha un indicatore di consapevolezza: una fila di punti, da uno a tre, per far pensare a una composizione esitante e ponderata da parte del computer. Kevin Munger, un politologo della Penn state university, ha proposto di regolamentare l’uso dei pronomi di prima persona, per “limitare il rischio che gli utenti siano truffati, sia economicamente sia emotivamente”. Ma lo stile di ChatGpt rimane quasi uniformemente rigido ed ellittico: anche se gli si può chiedere di riformulare le sue espressioni in diversi registri emotivi e affettivi, sembra ancora di conversare con una serie di equazioni. Rispetto all’immediatezza della vecchia Gchat, ChatGpt offre un’elaborazione dei dati mascherata da conversazione, parla al ritmo del discorso umano.

Per rendere i modelli linguistici di grandi dimensioni capaci di conversare, i loro sviluppatori arruolano esseri umani che addestrano e perfezionano il software. Ma l’aggiunta di interfacce in grado di dialogare con un consumatore è anche un modo di evocare familiarità, abitudini e attività già esistenti. La chat offre ciò che i motori di ricerca e i database non possono dare: un senso di coinvolgimento personale. Si rivolge alla singola persona, contribuendo così a incoraggiare determinati comportamenti. All’inizio di quest’anno, in un post di Medium intitolato Con chi stiamo parlando quando parliamo con questi bot?, Colin Fraser, un esperto di dati della Meta, ha scritto che “l’interfaccia di ChatGpt guida l’utente verso la produzione di input del tipo desiderato. Quando gli utenti si allontanano dal ruolo previsto”, dice, i modelli linguistici rischiano di produrre risultati indesiderati: frasi, o frammenti di frasi, che lasciano emergere il “generatore di testo sintetico senza cervello” che opera sotto la sua superficie. E conclude: “Il modello agisce in modo prevedibile solo quando l’utente agisce in modo prevedibile”.

Con i chatbot di oggi, le persone non parlano veramente ma suggeriscono. In questo contesto è usato il termine prompt per indicare le sollecitazioni che inducono il software a produrre risultati specifici. Nei documenti della OpenAi c’è una pagina sul “modo migliore per produrre risposte”, per esempio evitando le negazioni (“invece di dire cosa non fare, dire cosa fare”) e aggiungendo dettagli su “contesto, risultato desiderato, lunghezza, formato, stile” e tono della risposta. Alcune aziende che lavorano alla creazione di applicazioni di intelligenza artificiale assumono tecnici specializzati per sviluppare prompt utili o sequenze di prompt. Un annuncio di lavoro per un “tecnico bibliotecario di prompt”, pubblicato dall’azienda Anthropic, che definisce il suo chatbot Claude “utile, onesto e innocuo”, descrive il ruolo del tecnico richiesto come “un ibrido tra un programmatore, un istruttore e un insegnante”.

Se alcuni prompt producono dati di qualità superiore, cioè contenuti più leggibili, completi e talvolta più accurati, la progettazione dei prompt diventa una forma di alfabetizzazione. La scorsa primavera, il New York Times gli ha dedicato un articolo didattico intitolato “Ottieni il meglio da ChatGpt con questi fantastici suggerimenti”, che consigliava di usare l’espressione “comportati come se” per guidare i chatbot a “imitare un esperto”. Anche gli utenti, ovviamente, si comportano “come se”. Devono impegnarsi in atti di emulazione, stando al gioco, chattando in modo compatibile con un computer e sospendendo qualsiasi incredulità sulla sua competenza. Gli input di alta qualità sono premiati con output di alta qualità. Il software è una specie di specchio. Quello che succede è uno scambio di dati tra utente e bot, ma è anche una manipolazione reciproca, uno stimolo, uno scambio simbolico.

Alla conferenza degli sviluppatori di videogiochi, durante una pausa tra un incontro e l’altro, sono andata al centro commerciale lì vicino Metreon per pranzare in un ristorante vietnamita. Frequentavo regolarmente quel ristorante una decina d’anni prima, quando avevo venticinque anni e lavoravo da quelle parti all’assistenza clienti di una startup. All’epoca passavo le mie giornate a scrivere email che dicevano cose come “Mi piacerebbe riprodurre questo errore” e “Fammi sapere se questo ti aiuta!”. In quegli anni, il libro di Tony Hsieh Il segreto delle aziende in cui è (davvero) bello lavorare (Scuola di Palo Alto 2013) era di gran moda e si parlava molto di come regalare “sorpresa e gioia”. Era strano pensare a un futuro in cui questo lavoro potesse essere completamente automatizzato, in cui sarebbero stati gli llm, invece di laureati in studi umanistici, a svolgere il compito di trasformare la frustrazione e l’errore umano in qualcosa di utile e affascinante.

Il ristorante sembrava più o meno lo stesso, ma c’erano più schermi. La ciotola d’insalata fa parte delle cucine di tutto il mondo, ma nella cultura del pranzo aziendale implica anche un menù combinato ridotto agli elementi essenziali e c’erano persone con il pass della conferenza che scorrevano tablet per scegliere proteine, salse e condimenti. Dall’altra parte, una fila di camerieri trasferiva mucchietti di spaghetti di riso da freddi contenitori di metallo a contenitori compostabili. Quando è arrivato il mio turno, ho selezionato rapidamente gli ingredienti, quasi a caso, e ho immediatamente provato rimorso. Mentre assemblavano la mia ciotola, ho letto i commenti sul ristorante di Yelp, un sito di recensioni. “In assoluto, la loro insalata è imbattibile”, era un commento. “Hanno davvero riempito la ciotola fino all’orlo”, scriveva un altro. “La mia ciotola traboccava!”, affermava un terzo.

Sono sempre stata affezionata a Yelp, non come servizio ma come corpus letterario che documenta quasi vent’anni di desideri socioculturali e aspettative insoddisfatte: la cronaca di una generazione alla ricerca di un’esperienza ottimizzata. Il sito, fondato nel 2004, è il frutto perfetto del web 2.0, una versione della rete che ha prodotto nuovi tipi di contenuti generati dagli utenti. Tweet, post offensivi, commenti, recensioni: forme di scrittura pubblica ognuna con le sue convenzioni, abbreviazioni e tic lessicali (nel caso di Yelp: “Darei zero stelle se potessi”, “Sono molto sorpreso dalla valutazione”, “È un 3,5, ma arrotondato per difetto per la presentazione”). È stato quasi commovente vedere che molti modelli linguistici di grandi dimensioni siano stati addestrati sui contenuti del web 2.0. Le piattaforme aziendali, e i testi che le animano, sembrano vecchie e casarecce al confronto.

Mi chiedevo se i chatbot e altre interfacce in linguaggio naturale avrebbero prodotto nuove forme di conversazione, nuovi modi di parlare, nuovi tipi di contenuti. Proprio come Yelp ha influito sul modo in cui i suoi utenti giudicavano alcune esperienze offline – una visita dal chiropratico, il servizio in una pompa di benzina, le dimensioni di una ciotola per il pranzo – gli llm potevano influire sul modo in cui le persone cercavano ed elaboravano le informazioni. Già da allora, anche se generavano testi pieni di errori fattuali, i chatbot erano spacciati per strumenti di raccolta d’informazioni. Come avrebbero potuto influenzare le aspettative degli utenti o il loro atteggiamento nei confronti della competenza?

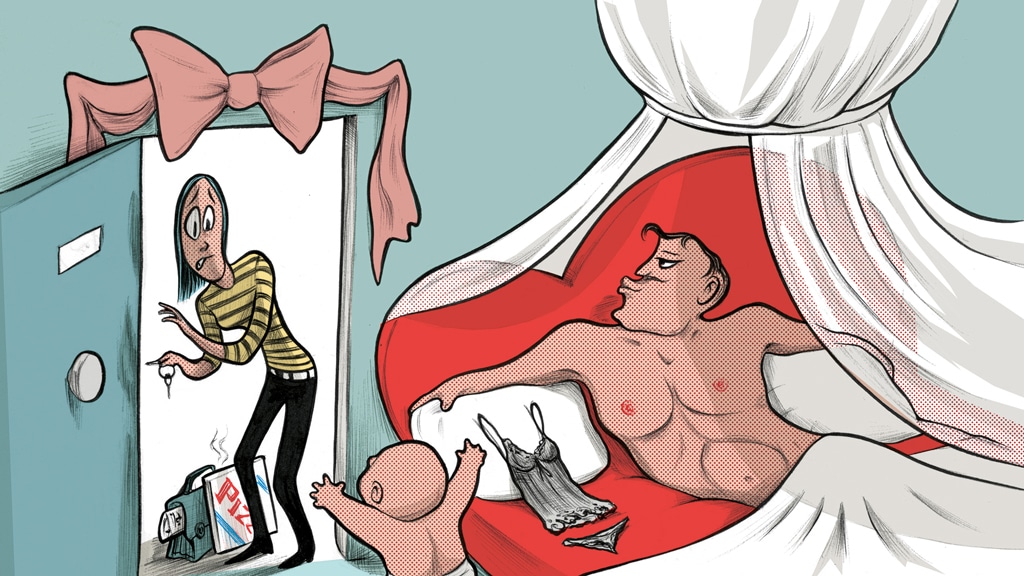

Portando con me la mia insalata, ho trovato una panchina in una piazza vicino al Moscone center. C’erano persone appoggiate all’edificio che fumavano sigarette vere o riunite in piccoli gruppi a sbuffare fumo elettronico. L’aria era profumata, inquinata e suggestiva, e il mio viso si scaldava al sole. Ho preso una strisciolina di jicama, nostalgica e felice, ricordando i pranzi della mia giovinezza. Ho ripensato a quando lavoravo all’assistenza clienti, a quando ogni tanto andavo nella sala dei server per rispondere alle videochiamate dei clienti, a come ogni tanto sembravano sorpresi d’incontrare la persona che riceveva le loro email e come cambiavano tono. La conversazione con un bot può essere efficiente, forse anche piacevole, a seconda del contesto e della nostra disposizione d’animo. Ma può anche suonare condiscendente, piatta, manipolativa e generica: in pratica può dare l’impressione di essere trattati come personaggi non giocanti. Ho mangiato il mio pranzo proustiano. I recensori di Yelp avevano ragione: la ciotola era stracolma.

Una volta tornata nel Moscone center, ho preso una scala mobile, ho svoltato diversi angoli, sono scesa per una rampa di scale e ho trovato due “spazi per l’allattamento” in quello che sembrava essere il seminterrato. Erano strutture indipendenti, prodotte da un’azienda chiamata Mamava, e avevano la forma a goccia dei rimorchi per camper. “Ciao, mamma!”, recitava una scritta di benvenuto sul retro della porta. “Rilassati. Te lo meriti”. Una piccola pianta di plastica era appoggiata su una mensola, accanto a uno specchio, e ho controllato il mio riflesso: dolcevita, zaino, pass al collo, occhi stanchi. “Ti vedo bene, mamma!”, cinguettava una decalcomania alla base dello specchio. Era tutto troppo affettuoso e banale.

La lingua può contenere un mondo intero che rivela la storia, i valori o le patologie di chi la parla. Può anche essere fuorviante e scivolosa. Una chat, con il suo tentativo di apparire familiare e di avere una personalità, può nascondere false promesse, banalità, vuoto, conflitti e il contesto della propria esistenza (nel 2022, in Cina, il suo mercato primario, la cernia taiwanese è stata vietata, costringendo i suoi produttori a cercare disperatamente nuovi consumatori). In questo senso, la chat simulata nasconde quello che ci vuole veramente per creare, addestrare, aggiornare e mantenere modelli linguistici di grandi dimensioni, che sono estremamente costosi e richiedono molte risorse. Rendere l’informatica più personale e intima è un’impresa enorme: dietro ogni chatbot c’è una rete o più d’una. Chiedere a un modello linguistico di grandi dimensioni di richiamare e organizzare dati comporta l’attivazione di una grande rete. I chatbot, nonostante tutta la loro apparente personalizzazione, rientrano nel campo della produzione di massa.

Tutte queste infrastrutture rinforzano una fantasia. Gli esperti di tecnologia sognano da tempo di avere relazioni interpersonali con i programmi. Recentemente, Sam Altman, l’amministratore delegato della OpenAi, ha spiegato al Wall Street Journal di essere come un bambino che sbirciando nel suo computer ha “improvvisamente realizzato” che “un giorno, le macchine avrebbero imparato a pensare” (il quotidiano usa il termine “realizzato” come se si trattasse di un fatto, non un’ipotesi). Non è ancora chiaro se gli llm o le tecnologie future saranno in grado di “pensare” in modo riconoscibile o significativo. A giugno, Marc Andreessen ha pubblicato un saggio, Why ai will save the world, in cui immagina un mondo di bot empatici, ben informati e motivazionali, “che massimizzano i risultati di ogni persona” e collaborano con artisti, scienziati, capi di stato e bambini. “Ogni bambino avrà un tutor basato sull’intelligenza artificiale infinitamente paziente, infinitamente comprensivo, infinitamente ben informato, infinitamente utile”, ha scritto Andreessen. “Quel tutor sarà al fianco di ogni bambino in ogni fase del suo sviluppo, e lo aiuterà a sfruttare al massimo le sue potenzialità con una versione automatica dell’amore infinito”.

Una volta tornata a casa, quando mi sono seduta da sola davanti al portale di ChatGpt, mi sono chiesta fino a che punto anche la più sofisticata intelligenza sintetica potesse far avanzare una tecnologia come questa, se potesse mai sembrare veramente partecipe o affidabile. Forse in futuro esisteranno una conoscenza infinita e un amore infinito, o almeno la loro versione automatica, prodotta, commercializzata e venduta da monopoli e aziende tecnologiche. Nel frattempo, ai bordi del mio schermo, le notifiche tremolavano e scivolavano via. Il mio telefono ronzava e la mia casella di posta si riempiva di titoli di giornale, notizie di lavoro, messaggi personali, battute, prese in giro, pettegolezzi. A breve termine, il futuro sembrava riservarmi infinite chiacchiere, non tra amici, e neanche tra estranei, ma con grandi server che si trovano in qualche angolo degli Stati Uniti e con un mondo d’interfacce caleidoscopiche in attesa di essere sollecitate, pronte a dire solo quello che gli utenti vogliono sentirsi dire. ◆ bt

Anna Wiener è una giornalista e scrittrice esperta di nuove tecnologie. È autrice di La valle oscura (Adelphi 2020). Questo articolo è uscito sul New Yorker con il titolo The age of chat.

Internazionale pubblica ogni settimana una pagina di lettere. Ci piacerebbe sapere cosa pensi di questo articolo. Scrivici a: posta@internazionale.it

Questo articolo è uscito sul numero 1527 di Internazionale, a pagina 88. Compra questo numero | Abbonati