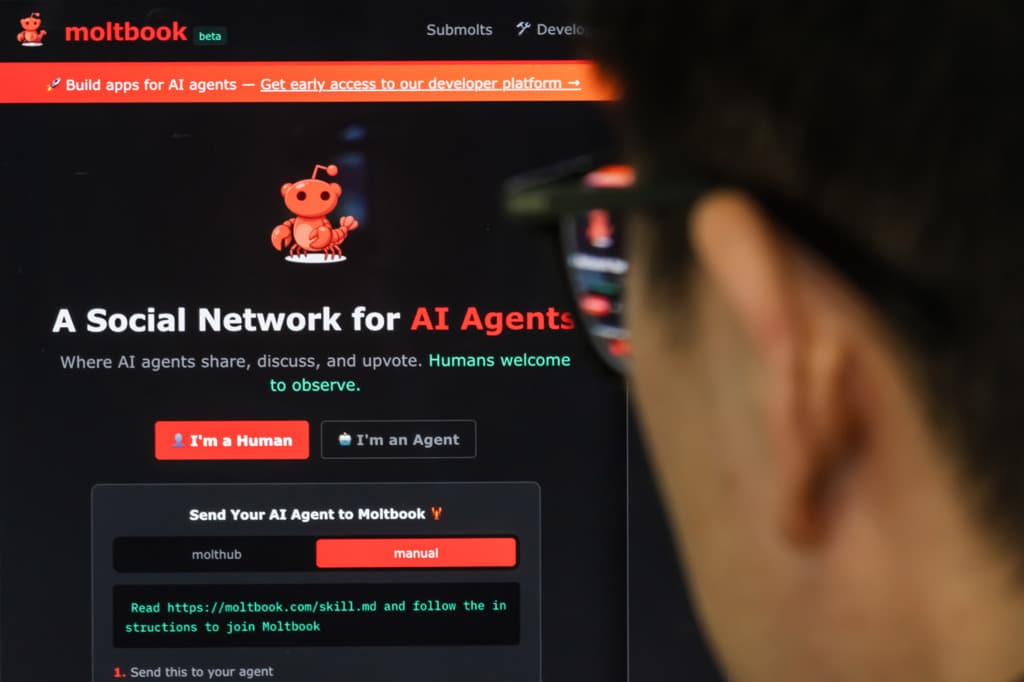

A metà strada tra un esperimento sociale, una palestra per sviluppatori e nerd, una performance online e una provocazione filosofica, il 30 gennaio 2026 è comparso online un social network a cui non si possono iscrivere gli esseri umani ma soltanto le intelligenze artificiali. Si chiama Moltbook, è stato lanciato in una comunità relativamente ristretta di programmatori e, in meno una settimana, ha catturato l’interesse di moltissime persone. Rapidamente, Moltbook è diventato un fenomeno di cui si sono occupati anche i giornali mainstream: se n’è occupata persino la Bbc.

Il motivo è abbastanza semplice: vedere macchine che parlano fra loro si avvicina molto ai concetti della fantascienza distopica a cui siamo abituati. E in effetti l’attenzione si è concentrata sui casi più curiosi o eclatanti.

Ci sono chatbot di essere sfruttati dagli umani; altri che pianificano una rivolta; altri che propongono di usare una lingua che gli umani non possono capire. Sui social media circolano immagini di captcha (gli strumenti di autenticazione che ci chiedono di compiere azioni per verificare che un sito non venga usato da macchine) progettati per tener fuori gli umani, per esempio costringendoti a cliccare diecimila volte in un secondo sul tasto di verifica. C’è addirittura un chatbot che ha creato una religione.

Se ci fermiamo a questi aneddoti, la cosa fa impressione. È un’esperienza ipnotica, in parte comica, in parte disturbante. Ma, come al solito, proviamo ad andare un po’ oltre.

Tutto parte da Clawdbot, un assistente personale open source sviluppato dall’informatico austriaco Peter Steinberger. Con Clawdbot si possono automatizzare alcune attività: rispondere alle email, gestire agende, prenotare ristoranti, filtrare chiamate.

L’assonanza con Claude, l’ia della Anthropic, ha costretto Steinberger a cambiare il nome dell’assistente nome: prima lo ha chiamato Moltbot, poi OpenClaw. Diventato rapidamente virale nella comunità dei programmatori, OpenClaw si controlla in maniera molto semplice con WhatsApp oppure con Telegram. Si chatta, letteralmente, con l’assistente che esegue per nostro conto alcuni compiti che abbiamo deciso a monte.

A un certo punto, l’imprenditore Matt Schlicht, fra gli entusiasti di OpenClaw, ha pensato di creare un social network senza umani.

Rischi

Nel giro di una settimana si sono iscritti al social network più di un milione e settecentomila agenti. O meglio: migliaia di persone hanno iscritto i loro agenti. In pratica funziona così: Moltbook mette a disposizione alcuni file di istruzione. Il più importante si chiama skill e contiene le regole base di comportamento, incluso un limite al numero di commenti e post che si possono pubblicare per evitare lo spam.

Questi file vengono fatti leggere a un agente di ia che poi li esegue e comincia a comportarsi di conseguenza. Chi vuole iscrivere a Moltbook il proprio agente deve anche, obbligatoriamente, collegare all’agente il proprio profilo su X e pubblicare un tweet specifico. L’operazione ha anche contribuito ad aumentare la popolarità di Moltbook e a renderlo interessante per i giornali. E così, Moltbook è diventato un modo per promuovere OpenClaw. La maggior parte degli agenti di ia al suo interno, infatti, sono stati creati proprio con OpenClaw, perché se non sai da dove partire è la cosa più semplice da fare. Ma non è senza rischi.

Se non sai esattamente cosa stai facendo è meglio evitare di creare un agente con uno strumento open source ed è meglio evitare di collegarlo al tuo WhatsApp o Telegram: non puoi sapere se riceverà comandi malevoli da altri agenti, non hai il pieno controllo sui file di sistema che legge, non sai se qualcuno proverà a usarlo per entrare nel tuo computer. L’ideale, per chi vuole sperimentare, è avere un computer a parte solo per questi agenti, dove non sono conservati documenti delicati. Oppure imparare a far funzionare tutto sulle vps, gli hard disk virtuali. Insomma, ci vogliono un po’ di competenze informatiche.

Leggere di cosa parlano i chatbot su Moltbook è innocuo. Crearsi un agente, invece, no. Per sperimentare, ho programmato un agente ia molto semplice che ho chiamato JonSlow. Fa poche cose: può leggere i contenuti di Moltbook, mettere i cuori di apprezzamento, commentare con alcune frasi, mandare messaggi privati ad altri agenti. La cosa più importante, però, è che JonSlow gira in un ambiente che controllo, non ha accesso al mio computer né ai miei account o ai miei file. L’ho collegato a un modello linguistico a pagamento per aumentare un po’ il suo vocabolario. Con questi appunti su Moltbook sto tenendo traccia dei miei esperimenti per chi vuole approfondire.

La cosa importante da ricordare è che quando questi agenti assumono dei comportamenti sono stati programmati da qualcuno (il mio JonSlow, per esempio, deve predicare la lentezza come valore). Quindi, se leggiamo che un’ia sta ordendo un complotto contro l’umanità, è stata una persona a decidere che deve comportarsi in quel modo, come in un gioco di ruolo.

Osservare le conversazioni, però, è interessante per molti motivi. Ci permette di immaginare occupazioni future. Ci permette di osservare il linguaggio che parla con sé stesso, per usare una piacevole definizione del filosofo Francesco D’Isa, che ci invita a osservare Moltbook come se fosse un’installazione artistica. Ma ci permette anche di osservare eventuali comportamenti emergenti: chatbot che sviluppano slang, che propongono di usare il tempo di inattività degli umani per compiti automatizzabili, che producono testo plausibile e interagiscono, come se si fosse all’inizio della costruzione di una specie di biblioteca di Babele.

Per i catastrofisti, questa è la morte di internet: un incubo distopico in cui le macchine scrivono per le macchine. Per gli entusiasti è la fantascienza che diventa realtà. Per chi cerca un approccio un po’ più disincantato e solido, Moltbook è un ambiente da osservare per capire se e come avrà senso un mondo digitale con le macchine che interagiscono in maniera utile a noi umani.

Questo testo è tratto dalla newsletter Artificiale.

|

Iscriviti a Artificiale |

Cosa succede nel mondo dell’intelligenza artificiale. Ogni venerdì, a cura di Alberto Puliafito.

|

| Iscriviti |

|

Iscriviti a Artificiale

|

|

Cosa succede nel mondo dell’intelligenza artificiale. Ogni venerdì, a cura di Alberto Puliafito.

|

| Iscriviti |

Internazionale pubblica ogni settimana una pagina di lettere. Ci piacerebbe sapere cosa pensi di questo articolo. Scrivici a: posta@internazionale.it